過去幾年,AI 繪圖的能力提升得很快,但它真正的轉折點,不只是在「畫得更像」,而是開始「更懂你在說什麼」。若把影像生成想成一個把雜訊逐步修成圖像的過程,那麼模型的核心差異,就在於它如何理解畫面整體、如何把文字指令融入每一步的修正。這條演進路線,常被概括為:從以 U-Net 為主的擴散模型,逐漸走向以 Transformer 為主的擴散模型。

以 Stable Diffusion 1.5、SDXL 為代表的早期主流做法,多以 U-Net 作為去噪主幹。U-Net 的設計擅長處理影像的局部細節,像是材質紋理、光影顆粒、筆觸質感等,因此在風格表現上常常很討喜。同時,文字提示通常先經由文字編碼器轉成向量,再透過 cross-attention 等機制注入到去噪網路,使模型能依照文字條件生成想要的內容。這套設計的優點是技術成熟、工具鏈與社群資源豐富,也較容易在消費級顯示卡上運行,因而催生了大量工作流程與應用。

不過,當需求從「一張好看的圖」走向「可控、可重複、符合規格的圖」,傳統架構的限制就會逐漸浮現。使用者常見的痛點包含:多物件關係容易混淆、左右或位置指令不穩、文字拼寫與排版難以精準,以及同一指令多次生成時構圖穩定性不足。這些問題並不代表模型無用,而是顯示它在「全局結構」與「語意對位」上的掌握,仍有先天上的限制。

因此,新一代影像生成模型的發展方向,開始嘗試以 Transformer 作為去噪核心,其中較早被廣泛討論的代表是 DiT(Diffusion Transformer)。Transformer 的關鍵特性在於自注意力機制能更自然地在整個畫面範圍內建立關聯,讓模型在生成過程中更容易同時兼顧整體構圖、物件之間的相對位置與比例關係。簡單來說,U-Net 很擅長把局部細節打磨漂亮,而 Transformer 更擅長把全局結構安排得合理。

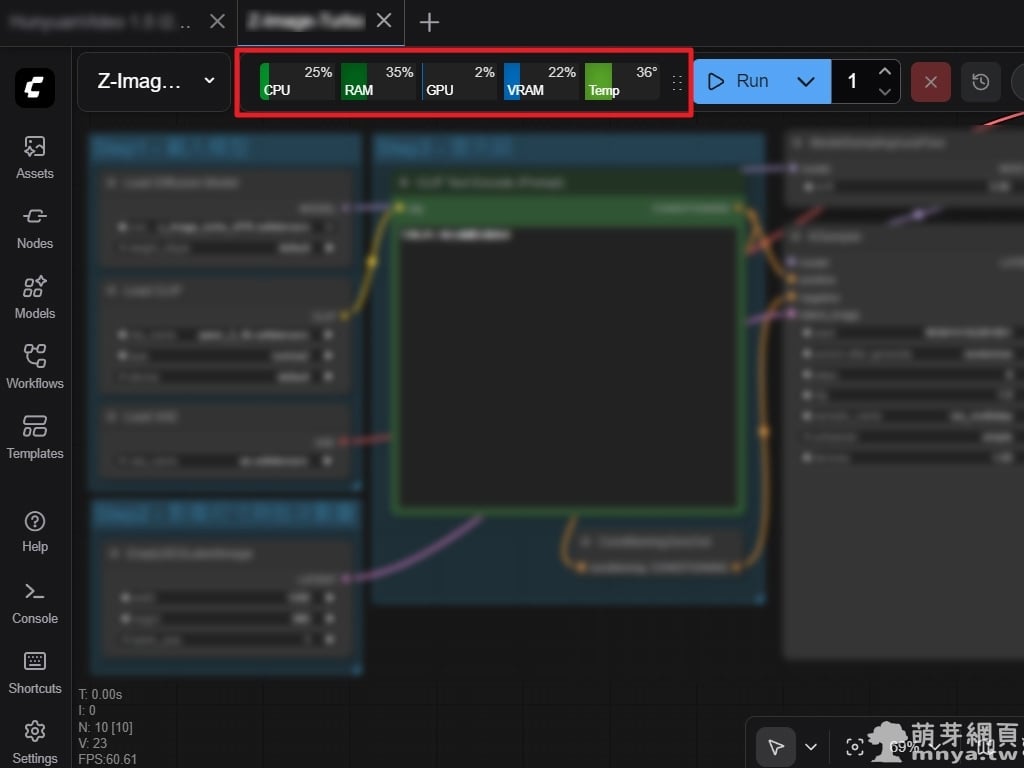

在這條路線上,Z-Image 是一個常被提及的研究案例。它提出以單一 Transformer 串流處理影像與文字條件的設計,嘗試減少傳統架構中條件注入的間接性。這類設計的重點並不在於風格多寡,而是在於提升語意對齊與空間關係的穩定度,讓模型在處理「位置描述」、「多物件關係」等指令時,有更一致的行為表現。對一般使用者而言,Z-Image 的意義在於展示了 Transformer 路線在結構理解上的潛力,而非作為風格生成的主流工具。

以下表格以較保守的方式,整理兩種路線在大眾使用時最常感受到的差異:

| 面向 | U-Net 為主的擴散模型(例:SD 1.5、SDXL) | Transformer 為主的擴散模型(例:DiT、SD3、Z-Image) |

|---|---|---|

| 核心強項 | 局部細節與材質紋理表現成熟 | 全局關係建模更自然,構圖與語意對位潛力較高 |

| 文字控制 | 常以 cross-attention 將文字條件融入去噪 | 以多模態 Transformer 設計強化文字理解與對齊 |

| 典型體感 | 風格資源多、流程成熟、好上手 | 更重視「照指令做」與「結構正確」的方向 |

| 實務取捨 | 社群模型與外掛生態龐大,迭代速度快 | 仍在快速演進期,工具鏈逐步補齊 |

總結來說,「U-Net 到 Transformer」並不是誰取代誰的單行道,而是影像生成從偏重視覺質感,逐步走向更重視語意理解與結構可控的自然演進。對一般使用者而言,如果需求以風格探索、插畫質感與快速出圖為主,U-Net 系仍然非常實用;若需求更偏向商業素材、產品包裝,或需要穩定構圖與更準確的指令遵循,那麼以 Transformer 為核心的設計,將會是值得持續關注的方向。未來的影像生成模型,很可能同時融合兩者的優點:既要好看,也要聽得懂,還要可控、可重複。

《上一篇》OBS:將螢幕劃分四等分,打造即時縮放的電腦操作教學錄影

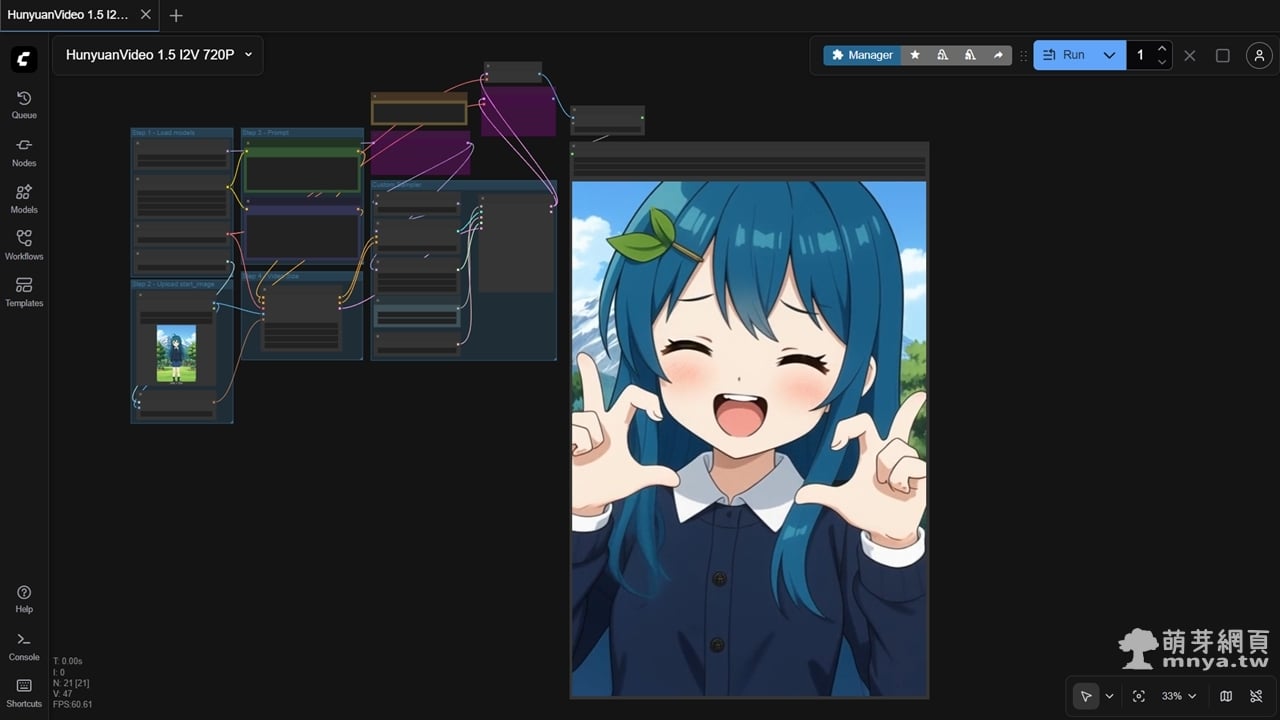

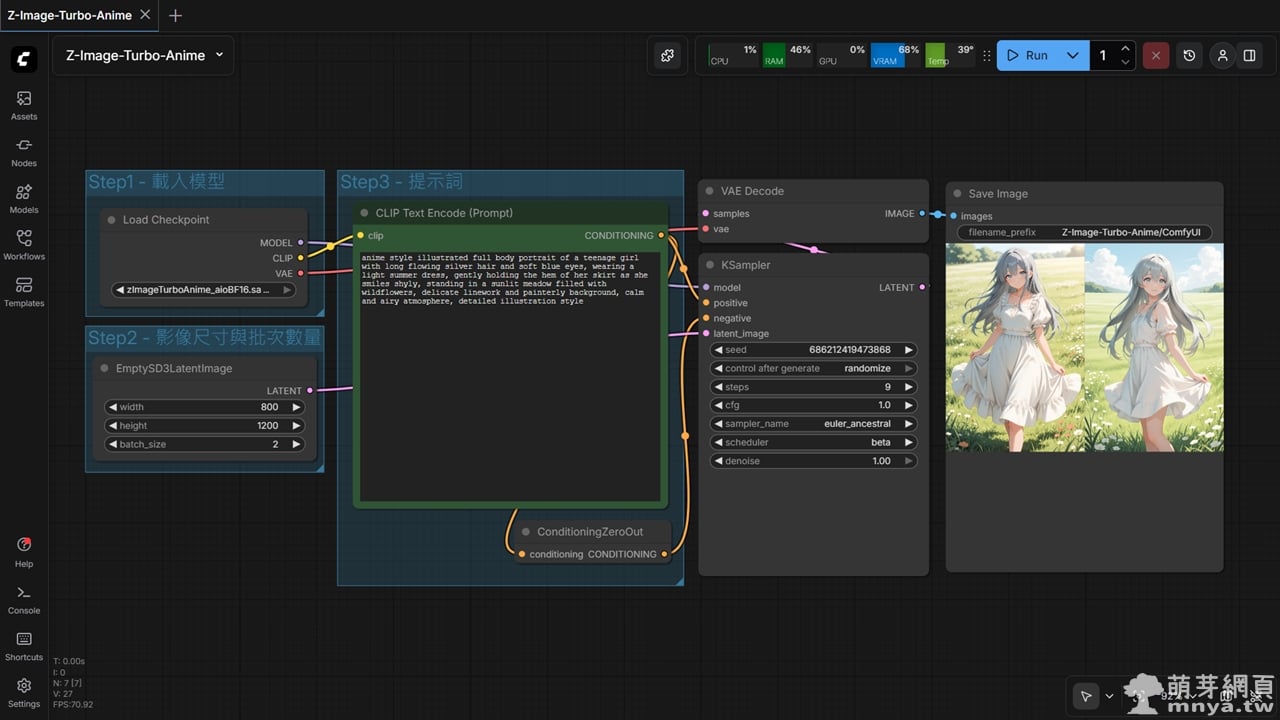

《上一篇》OBS:將螢幕劃分四等分,打造即時縮放的電腦操作教學錄影  《下一篇》ComfyUI x Z-Image-Turbo-Anime:單一模型生成高品質二次元動漫插圖(附工作流)

《下一篇》ComfyUI x Z-Image-Turbo-Anime:單一模型生成高品質二次元動漫插圖(附工作流)

留言區 / Comments

萌芽論壇