隨著開源影片生成技術逐漸成熟,即使在 GPU 資源有限的情況下,也能實現具備高完成度的角色動畫作品。WanGP 正是為此而生的整合型平台,透過友善的 Web 介面與高度模組化的設計,讓使用者能在本地端輕鬆完成從模型選擇、素材輸入到影片輸出的完整流程。本篇主題將聚焦於實務操作層面,說明如何利用既有的舞蹈影片作為動作來源,驅動指定角色圖像產生自然流暢的跳舞動畫,降低傳統動畫製作的技術與時間門檻。

在眾多模型之中,Wan 2.2 Animate 憑藉對人物動作與表情的精細掌控,成為角色動畫應用的核心選擇。透過「控制影片+角色參考圖」的方式,系統能準確擷取舞蹈節奏與肢體動態,並套用至目標角色,同時維持外觀與風格的一致性。搭配 WanGP 內建的解析度配置、影格數控制與分段生成機制,即使在顯示卡記憶體有限的環境下,也能穩定輸出長度完整、動作連貫的跳舞影片。以下將依照實際介面截圖,逐步說明設定重點。

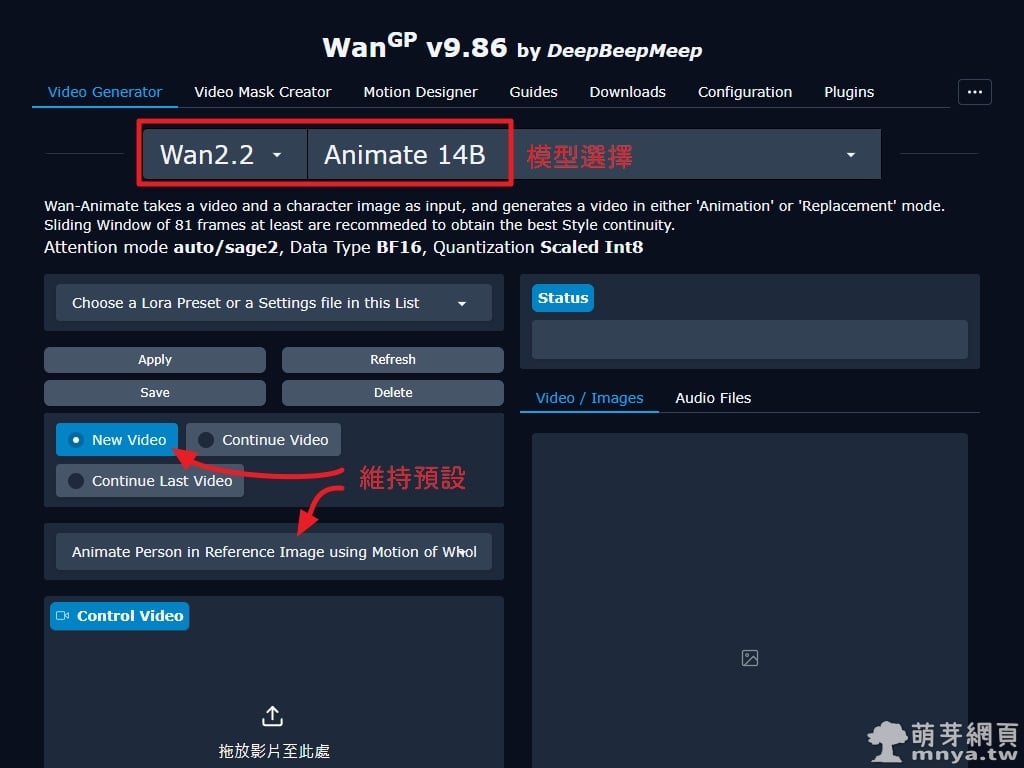

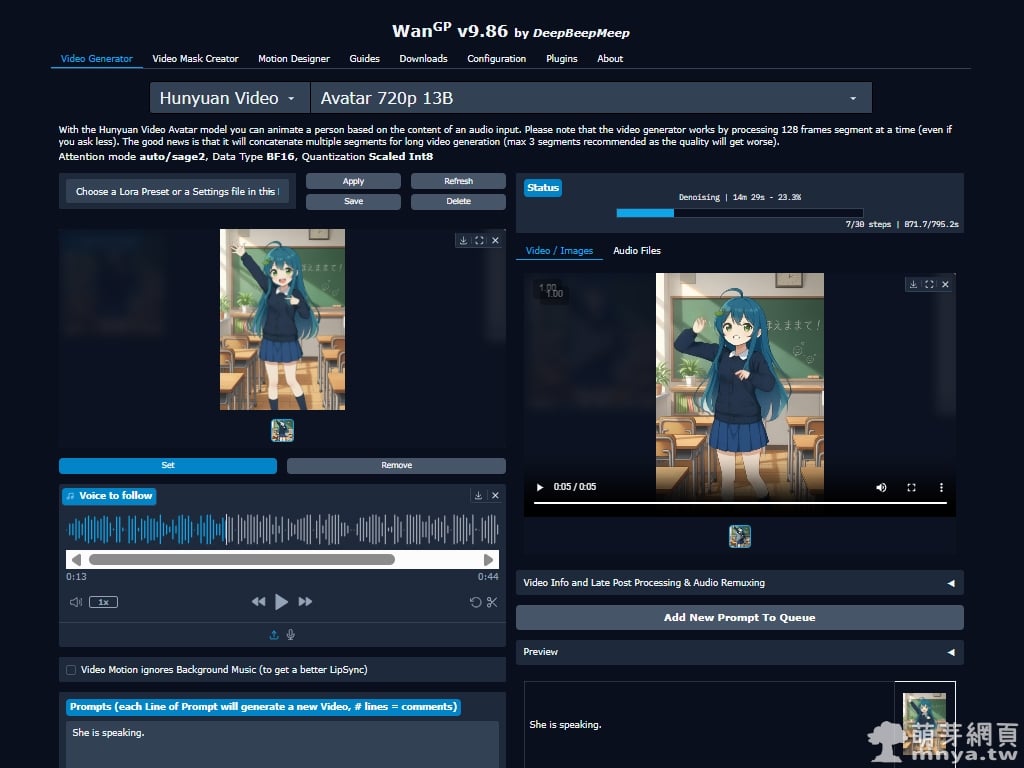

▲ 在 WanGP 的 Video Generator 中選擇 Wan 2.2 Animate 14B 模型。下方箭頭處設定維持預設即可,適合首次生成或單段影片測試。

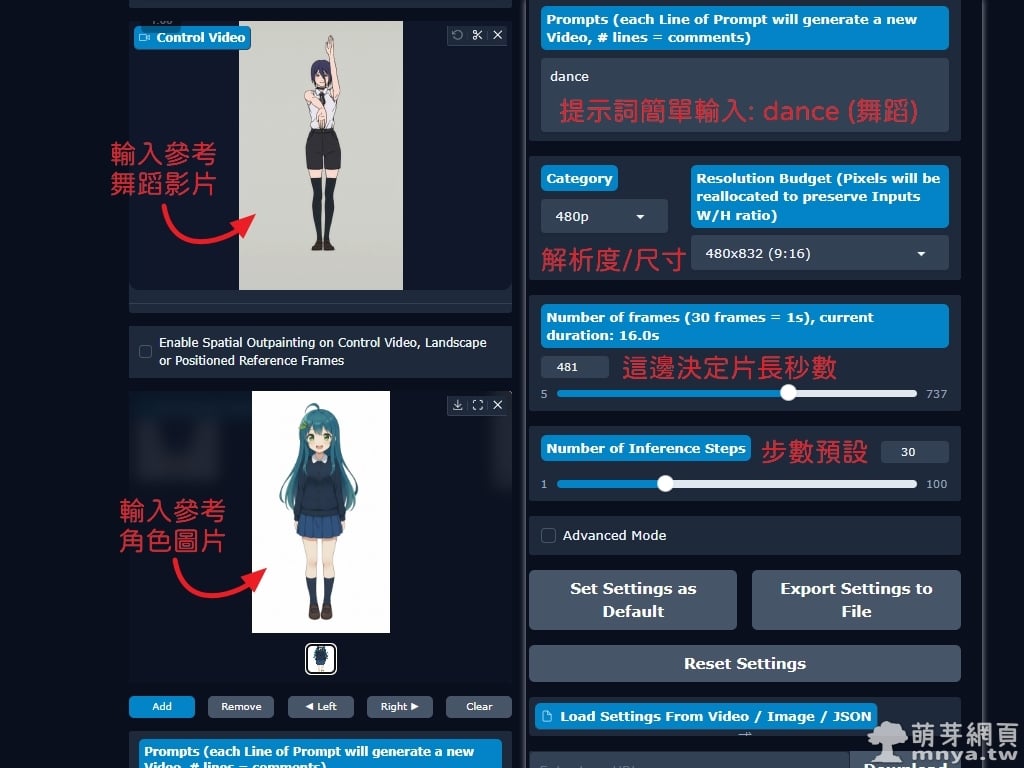

▲ 接下來需同時放入參考舞蹈影片與角色圖片。提示詞僅需簡單輸入,如 dance 即可。尺寸依照需求設置,秒數則跟參考影片同樣長度(實際上是設定幀數,1 秒 30 幀)。步數維持預設 30。

▲ 狀態與輸出區域顯示實際生成進度,當影格數超過顯示卡負荷時,WanGP 會自動採用 Sliding Window 分段生成。完成後,結果影片將統一顯示在下方 Video / Images 區塊。在 RTX 5070 Ti 16GB VRAM 環境下,每 4 秒影片約需 30 分鐘生成,此次 16 秒短片花費 2 小時整生成,平均消耗 VRAM 約 12.2 GB,效能表現供大家評估參考。

▼ 示範影片:萌芽娘參考『跳舞的蕾潔 x 米津玄師「IRIS OUT」』跳舞。

特別挑選這個短影片舞蹈主要是因為近期熱度高且長度很合適。舞蹈本身有不少相對複雜的動作,也算是給 AI 一些難度。生成效果蠻適合做娛樂短片的,崩的蠻好笑的,時間長度越長似乎崩壞越嚴重。

▶️ 更多示範:

▲「ごはん食べヨ・領域展開」萌芽娘迷因舞蹈短影音。

▲「ごはん食べヨ・領域展開」AI 少女迷因舞蹈短影音。

《上一篇》WanGP x HunyuanVideo-Avatar:參考音源製作 AI 對嘴影片

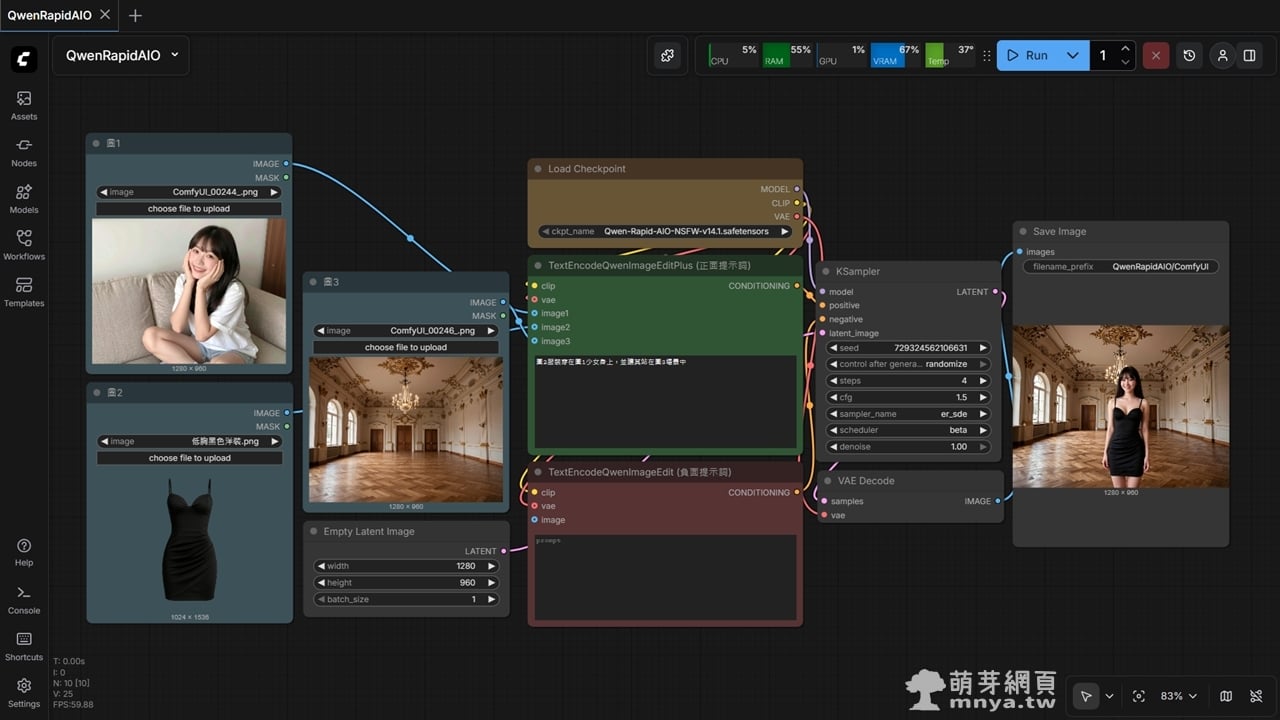

《上一篇》WanGP x HunyuanVideo-Avatar:參考音源製作 AI 對嘴影片  《下一篇》ComfyUI x Qwen-Rapid-AIO:圖片編輯工作流的極簡解法(附工作流)

《下一篇》ComfyUI x Qwen-Rapid-AIO:圖片編輯工作流的極簡解法(附工作流)

留言區 / Comments

萌芽論壇