在 AI 圖像生成發展迅猛的當下,從靜態圖片延伸至連貫動態的影片生成,一直是許多創作者與研究者追求的目標。FramePack,作為一套由 lllyasviel 釋出、針對「逐幀預測」優化的開源影片生成工具,不僅大幅降低運算門檻,更在本地端部署與推理效能之間找到了理想平衡。這讓我們能在不中斷創作流程的情況下,穩定輸出具備視覺連貫性與時間邏輯的高品質影片內容。

與傳統需要高資源與長等待時間的影片擴散模型不同,FramePack 採用了名為「Packing Input Frame Contexts」的創新架構,透過上下文壓縮設計,讓模型的運算負擔不再隨影片長度而倍增。根據官方數據,即使用 13B 模型生成 60 秒(1800 幀)影片,每段僅需約 6GB GPU 記憶體即可執行,在支援 fp16/bf16 的 RTX 30 系列顯示卡上皆可啟動,雖然速度不若高階設備(如 RTX 4090)快速,但效能仍足以支撐完整的影片生成體驗。

更關鍵的是,FramePack 完全免費、無需註冊,可離線本地運行,且具備直觀的圖形化介面(GUI)與開箱即用的範例素材。這些特點使它成為不論是個人創作者、技術實驗者,甚至內容工作室都能納入流程的實用工具。本文將透過實機操作,帶領你親自體驗這款圖生影技術的核心實力,並探索它在真實工作場景中的應用潛力。我這邊的顯示卡為 GeForce RTX 3060,GPU 記憶體(VRAM)有 12 GB,電腦記憶體(RAM)有 32 GB。

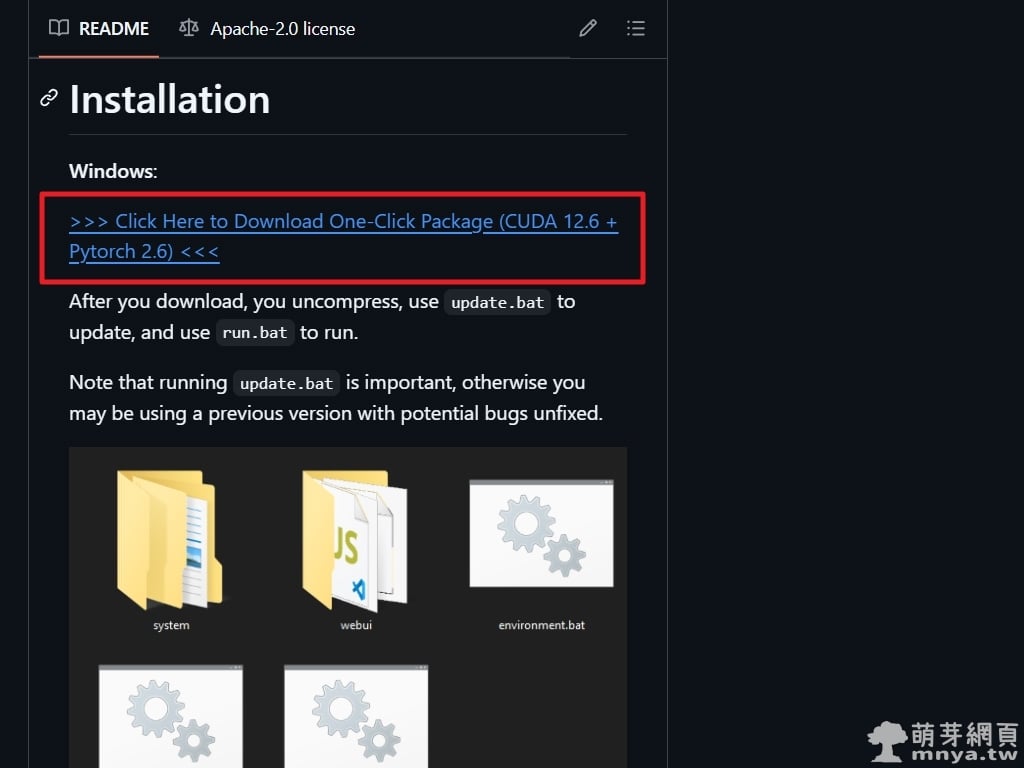

▲ 從 FramePack 的 GitHub 頁面開始,點擊「>>> Click Here to Download One-Click Package (CUDA 12.6 + Pytorch 2.6) <<<」下載 CUDA 12.6 與 PyTorch 2.6 整合包,檔案解壓後即可看到相關資料夾與執行檔,準備進入下一步安裝流程。

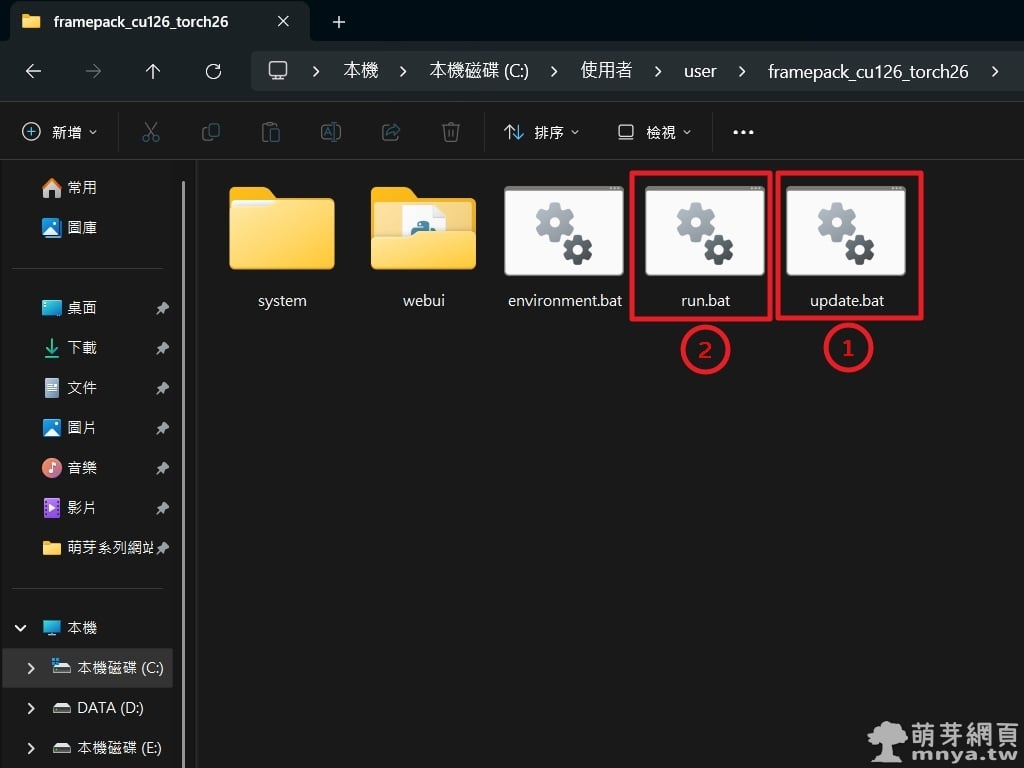

▲ 解壓後的資料夾內含 system、webui,首先執行 update.bat(標記 1)更新程式,確保版本最新,接著雙擊 run.bat(標記 2)啟動圖形化介面。

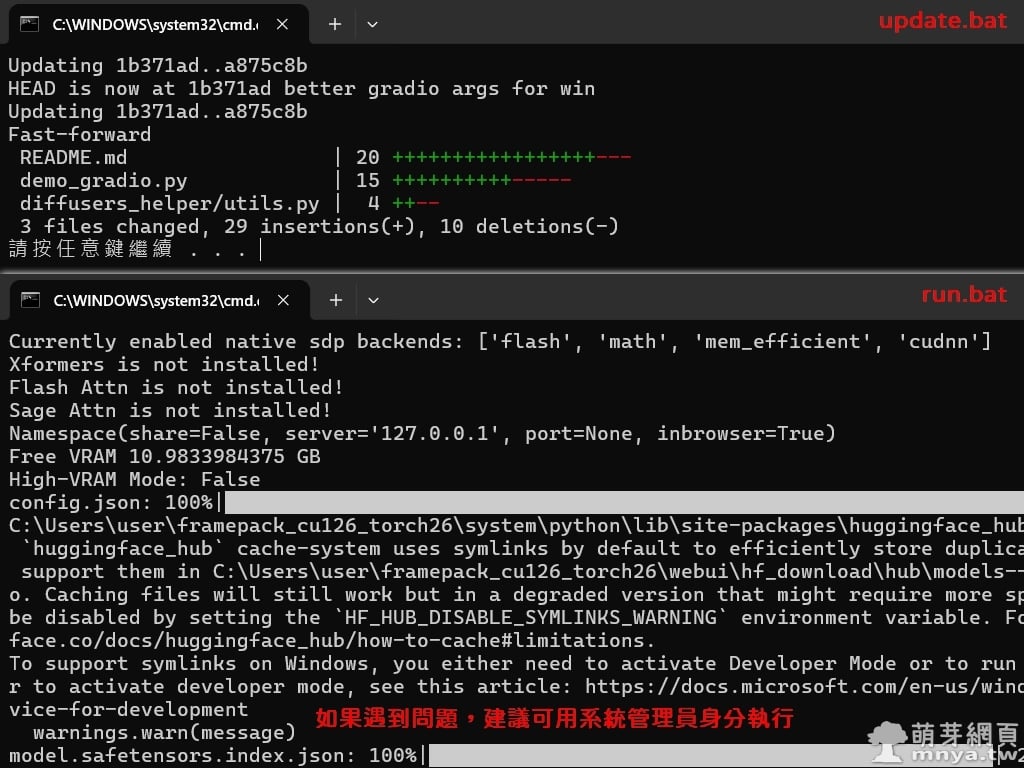

▲ 執行 update.bat 確保程式更新,顯示版本號與檔案變更訊息;執行 run.bat 時,若遇到問題,建議可用系統管理員身分執行。執行 run.bat 後,終端機會顯示模型與資源下載進度,初次啟動會自動從 HuggingFace 下載超過 30 GB 檔案。

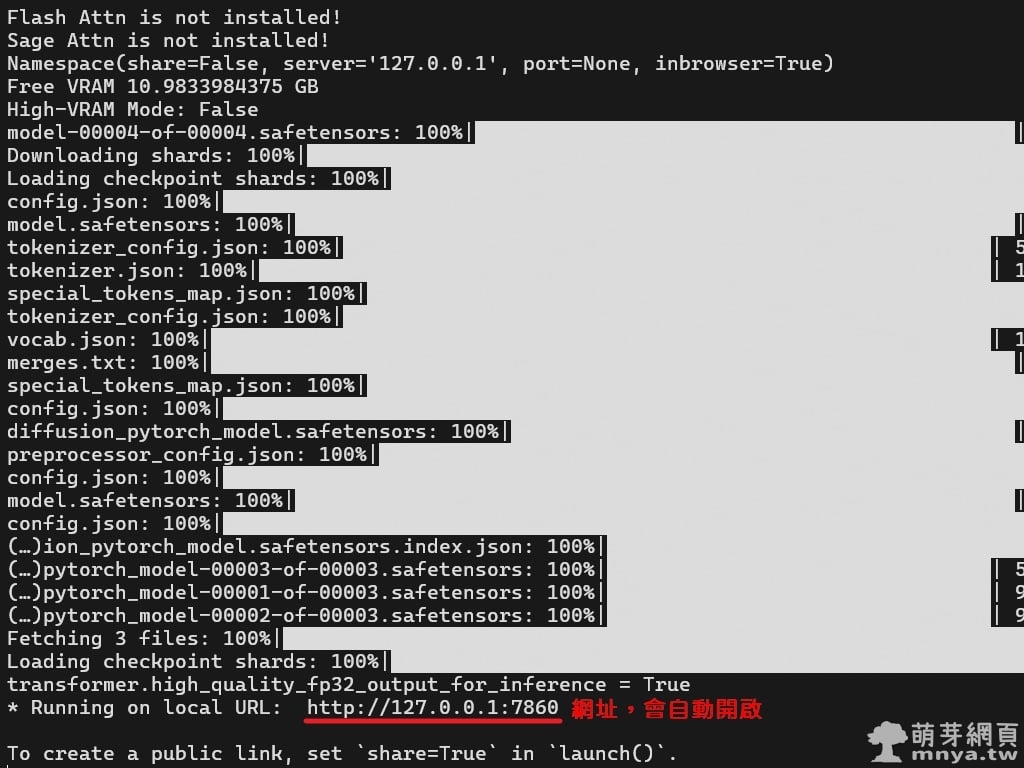

▲ 完成下載後將顯示本地 URL http://127.0.0.1:7860,介面也會自動啟動。

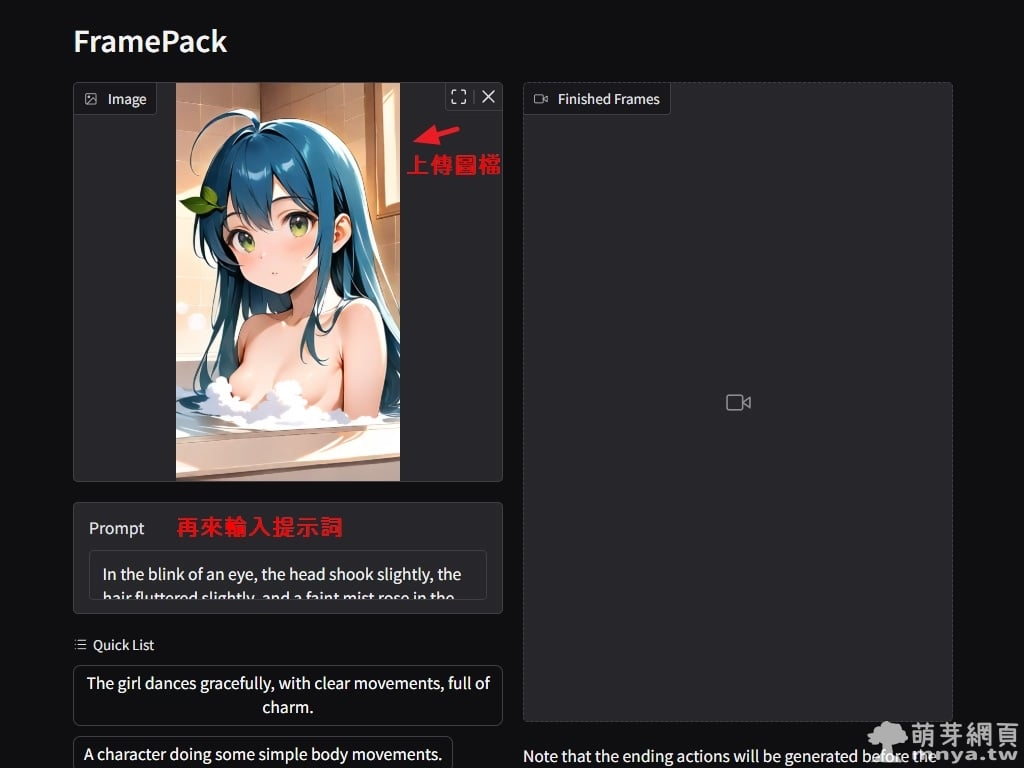

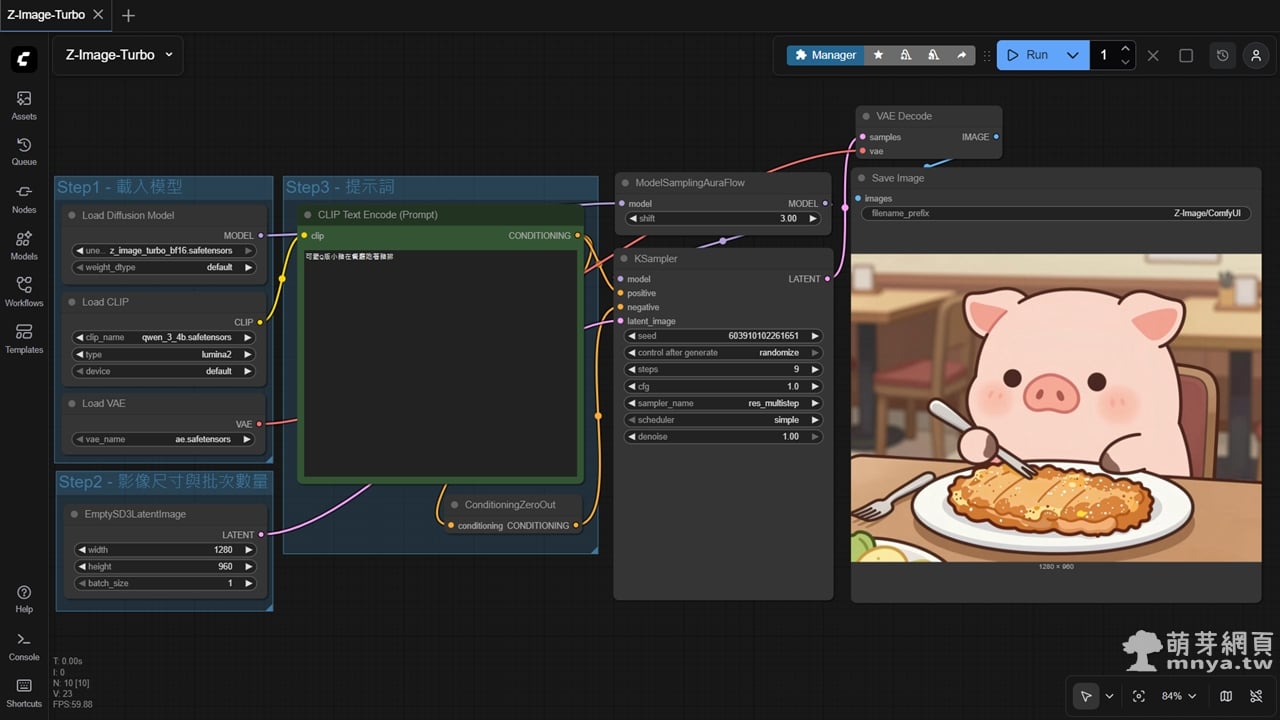

▲ 進入 FramePack 介面,我上傳自創 AI 繪圖「萌芽娘(沐浴)」作為輸入參考圖,寬高為 432 x 768 px(寬高越大,生成時間越久),接著填入提示詞「In the blink of an eye, the head shook slightly, the hair fluttered slightly, and a faint mist rose in the space.」。

🤔 深度思考:為何選用這張圖呢?首先我已經試過將其上傳至 Hailuo AI,未通過其社群規則,因此無法順利生成 AI 動畫,再來我已經在一開始用 SDXL 生成圖像時就請 AI 刻意處理重點部位進行遮蔽,雖然擦邊,但應不會有任何問題。由此也可驗證本地跑 AI 真的是很有優勢,不會被平台規則綁住,尤其是過於嚴格的規則,實現真正的創作自由,當然最終成品若要上傳到任何平台時,也請注意不要違反這些平台的相關規則。

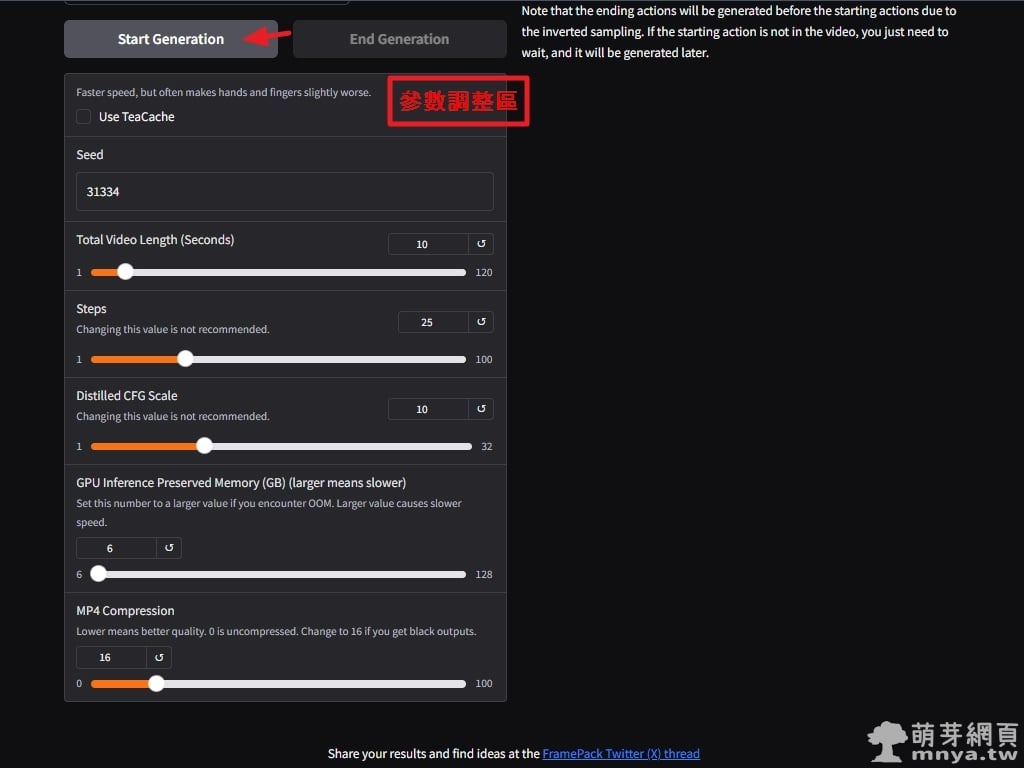

▲ 調整參數如總影片長度設為 10 秒,建議保持預設的 Steps(25)、Distilled CFG Scale(10),並將 GPU 記憶體保留設為 6 GB,點擊「Start Generation」開始生成。TeaCache 是 FramePack 提供的一種加速生成技術,透過預先快取部分計算結果來提升影片生成的效率,但並非完全無損,可能影響最終畫質;開發者建議先用 TeaCache 測試創意,再以完整擴散流程生成高品質成果。

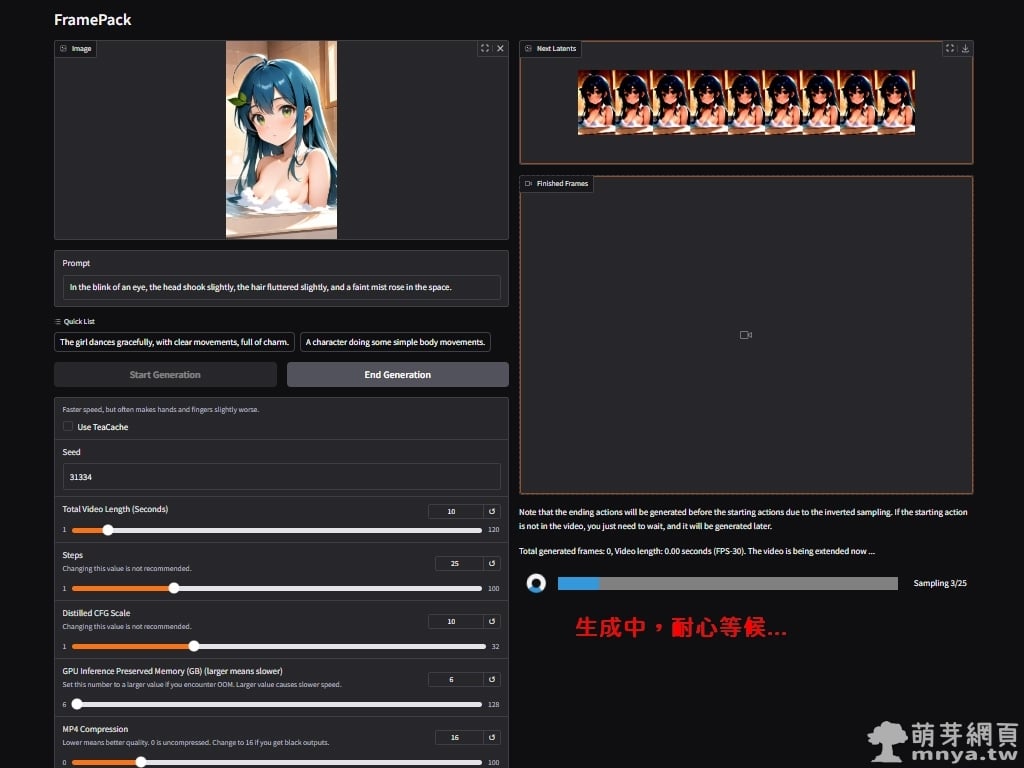

▲ 生成中,根據終端機資訊,沒使用 TeaCache 的情境下第一秒耗時約 14 分 26 秒、第二秒約 13 分 47 秒,總計生成 10 秒影片需耐心等待,過程中可見幀數逐步完成。如果過程中發現效果不如預期,可隨時點選「End Generation」停止生成。像我覺得這次生成沒達到我的預期,因此在第七秒生成時停止,但仍會保有前面已生成完成的秒數。

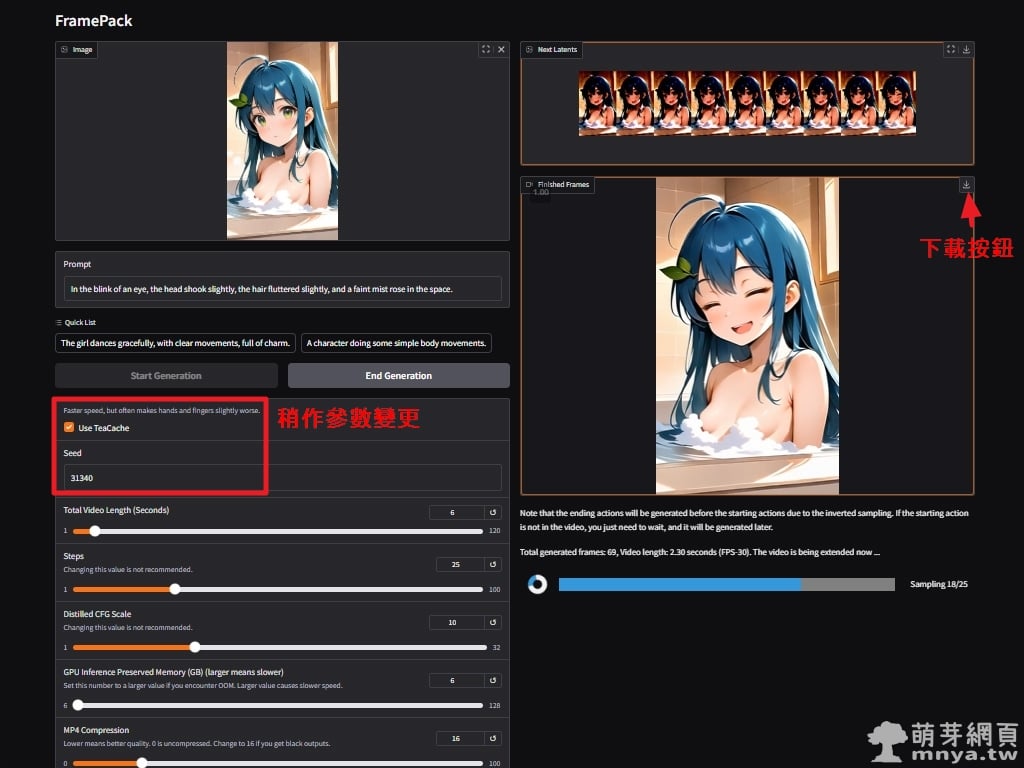

▲ 第二次嘗試將 TeaCache 啟用,並變更種子碼,其他含參考圖片、提示詞都不變動,實測第一秒耗時約 9 分 48 秒、第二秒約 7 分 20 秒、第三秒 7 分 29 秒,後續都差不多這時間。很明顯節省不少生成時間,個人認為若沒有太大動作,手部甚至沒有露出,可以直接將 TeaCache 啟用。預覽處右上有下載按鈕可以下載 MP4 影片檔案,生成完畢後下載的就會是完整的影片檔案,也可以從以下路徑找到影片檔案。

📝 影片預設輸出路徑:framepack_cu126_torch26\webui\outputs

我後來認為應該是提示詞的問題,導致動作比較僵硬,因此將提示詞更換為「Blink a few times, move your head from side to side, your hair flutter in the wind, and steam rises.」,來看看最後的成品,我已經將三部作品剪輯在一起:

▲ 影片欣賞《【FramePack】示範影片:萌芽娘(沐浴)》,輸出寬高為 480 x 832 px,音效另外由 MMAudio 生成。

🎬 更多作品參考

👉【AI 動畫】鈴森千花(隨興旅 -That's Journey-)(FramePack)

👉【AI 動畫】萌芽娘(萌芽系列網站)(FramePack)

👉【AI 動畫】榎本凜音(男女之間存在純友情嗎?(不,不存在!))(FramePack)

👉【AI 動畫】橘光(蔚藍檔案 Blue Archive)(FramePack)

👉【AI 動畫】橘希望(蔚藍檔案 Blue Archive)(FramePack)

綜合本次使用 FramePack 的體驗,即使在如 GeForce RTX 3060 這樣的中階顯示卡上,也能夠順利運行並生成具備一定連貫性的短影片,這無疑為許多預算有限或不追求極致速度的創作者開啟了全新的可能性。儘管生成速度仍有提升空間,尤其在生成較長或細節複雜的影片時需要一定的耐心,但其本地部署、離線運作以及完全免費的特性,使其在注重隱私、網路環境不穩定或僅想進行初步實驗的場景中,展現出獨特的優勢。

FramePack 直觀的圖形化介面和開箱即用的範例,也大幅降低了使用門檻,讓使用者能快速上手,將靜態的創意轉化為動態的視覺呈現。透過調整提示詞、種子碼等參數,以及靈活運用 TeaCache 功能,使用者可以在生成速度和品質之間找到適合自身需求的平衡點。可以預見,隨著 FramePack 的持續發展與優化,這項技術將在個人創作、藝術實驗、甚至商業內容製作等領域發揮越來越重要的作用,為影像創作帶來更多元的可能性。

📝 延伸學習

《上一篇》MMAudio Web UI:從影片或文字一鍵生成音效的 AI 工具教學

《上一篇》MMAudio Web UI:從影片或文字一鍵生成音效的 AI 工具教學  《下一篇》Docker Compose 快速安裝 Node-RED

《下一篇》Docker Compose 快速安裝 Node-RED

留言區 / Comments

萌芽論壇