解決搜尋引擎蜘蛛導致主機資源滿載和網站掛掉的問題、.htaccess 擋壞蜘蛛

2017/09/05

萌芽站長

411 1

網站技術 , 伺服器

⚠️ 溫馨提醒:我們發現您可能啟用了廣告阻擋器,請將本站加入白名單以正常閱讀文章內容,謝謝支持 ❤️

搜尋引擎的運作原理就是利用蜘蛛(一種自動掃描網站的機器人)掃描每個網站,以建立索引讓大家輕鬆搜到網站,不過目前大多數人只用 Google、Yahoo 等幾個知名搜尋引擎,但一些小型搜尋站的蜘蛛又會跑來掃描我們的網站,有些還非常暴力,就好像別人來 DDOS 你的網站一樣,導致主機資源滿載和網站掛掉!解決方式就是阻擋這些小蜘蛛、壞蜘蛛,如此一來就可以解決網站癱瘓的問題。圖文一開始先說明被蜘蛛搞到主機滿載的狀況,再來說明如何看是哪個蜘蛛來搞破壞!最後明白告知大家解決方式。

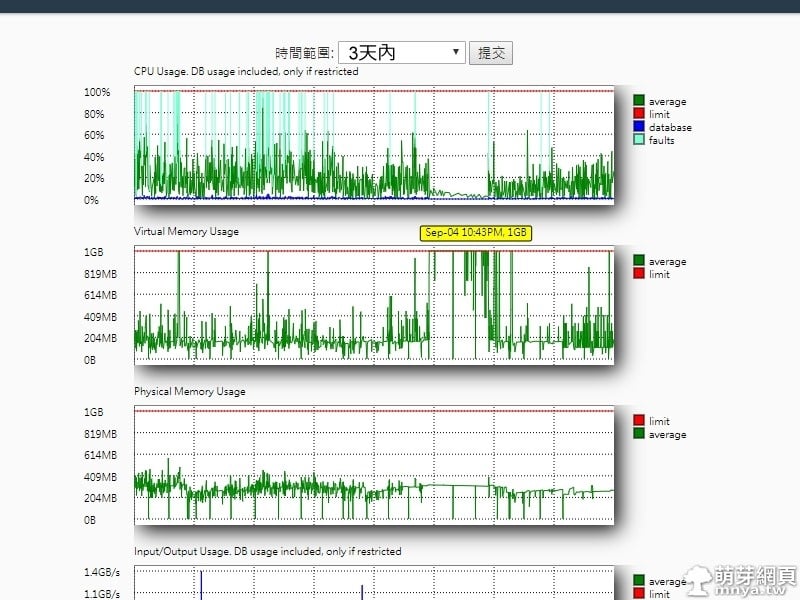

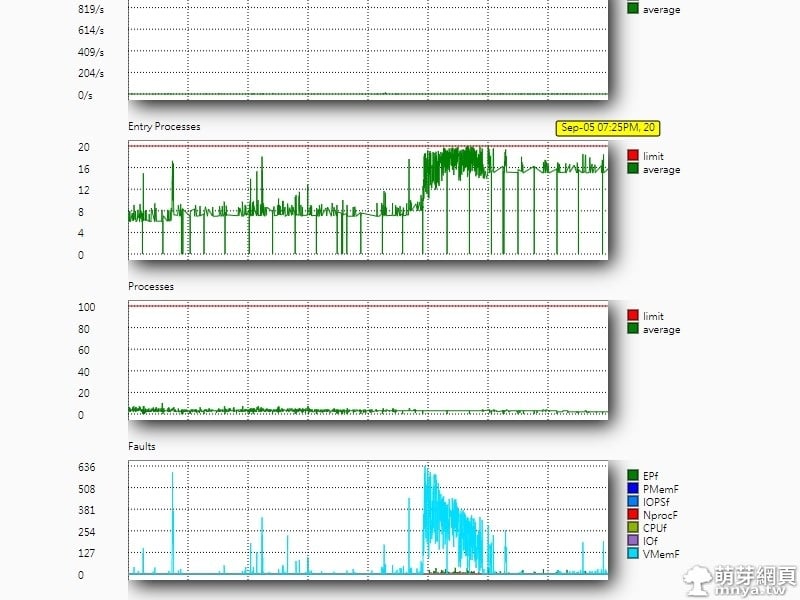

▲主機後台的「資源使用狀況」,這是三天內的資料,可以看出中間有段異常,這段時間網站是很難連入的。

▲同一個資料下方的其他項目數據,中間那段明顯異常,有些值都抵達限制了!

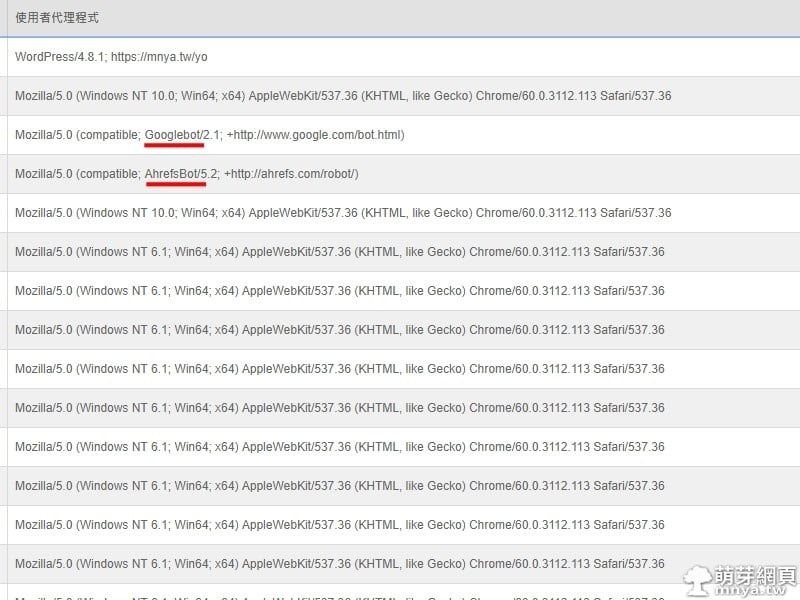

▲主機後台「訪客」部分,紅色底線標示的就是搜尋引擎蜘蛛。

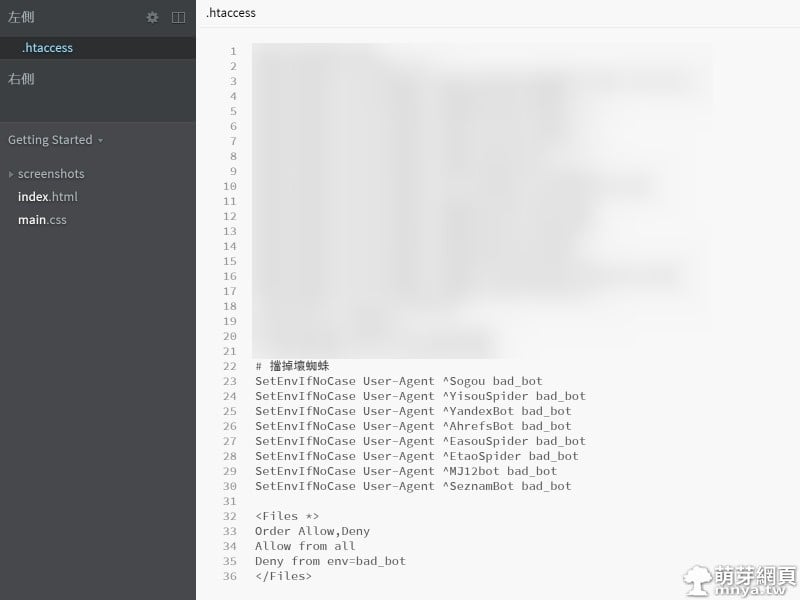

▲基本上這邊非常推薦使用「.htaccess」阻擋壞蜘蛛,截圖為範例,原始碼如下:

SetEnvIfNoCase User-Agent ^壞蜘蛛名稱 bad_bot

<Files *>

Order Allow,Deny

Allow from all

Deny from env=bad_bot

</Files>

「壞蜘蛛名稱」請填入壞蜘蛛的名稱,這邊可以至後台「訪客」查看,舉例:「Sogou」即搜狗的蜘蛛,整行意思是封鎖「壞蜘蛛名稱」開頭的蜘蛛,可以新增無限數量的壞蜘蛛。

有任何意見、錯誤都可以告知我,此為站長修復網站後的心得文章,歡迎參考!

贊助廣告 ‧ Sponsor advertisements

List Category Posts(WordPress 外掛):使用短代碼在頁面、文章內加入文章列表

📆 2019-03-17

📁

網站技術, 架站程式, WordPress

升級 Ubuntu 版本教學

📆 2024-07-09

📁

作業系統, 伺服器, Linux, Ubuntu

資料庫基本知識 & 筆記

📆 2019-04-10

📁

網站技術, 伺服器, 資料庫, 學業筆記, 學術詞彙, SQL

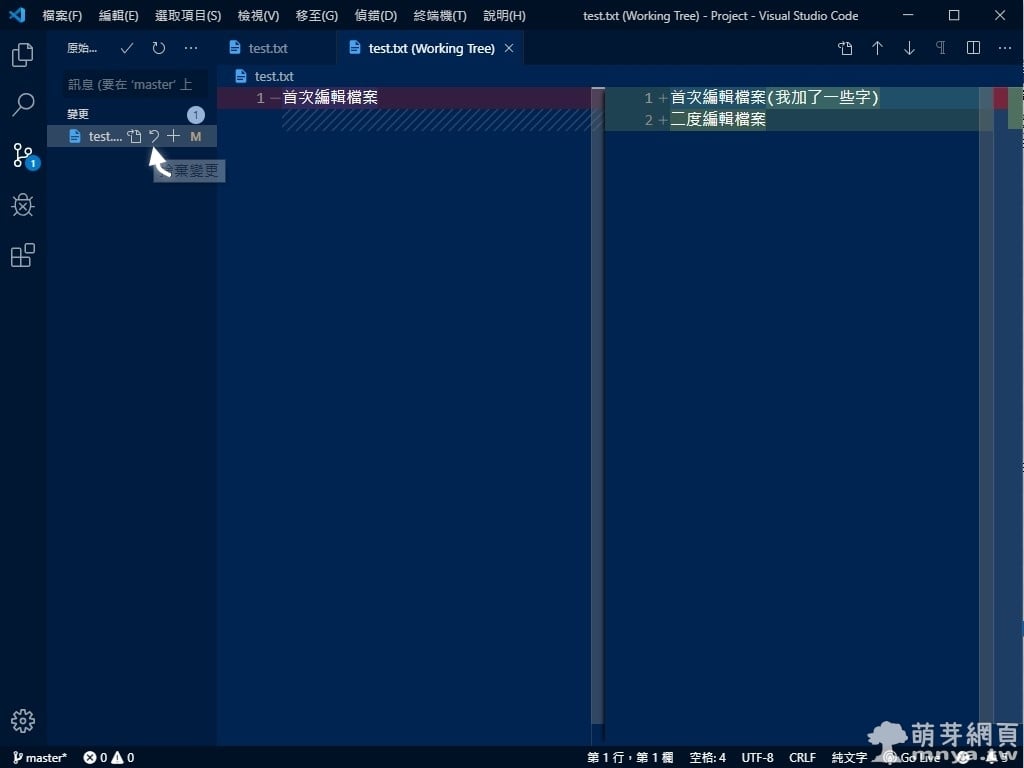

Git 版本控制:建立與初始化本地倉庫、暫存與認可變更(使用 VS Code)

📆 2019-09-18

📁

軟體應用, 網站技術, 程式設計

GitHub Pages x GitHub Desktop:在 GitHub 上建立靜態網站可供即時瀏覽

📆 2020-04-21

📁

軟體應用, 網路應用, 網站技術

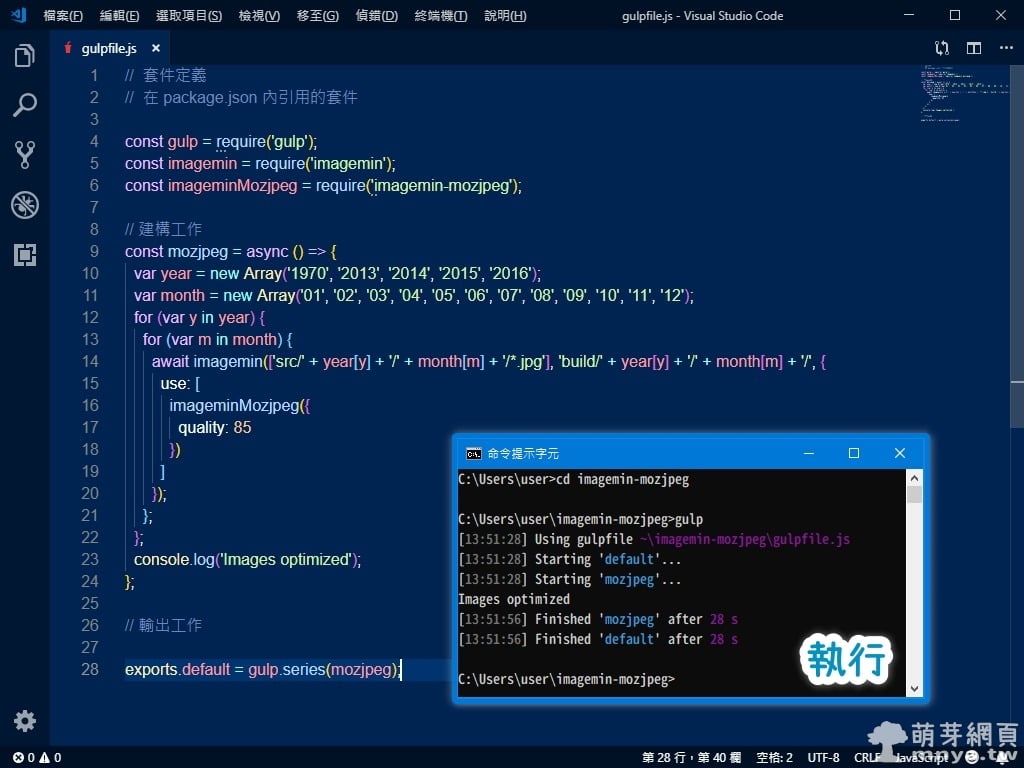

Node.js:處理多層目錄檔案(Gulp、mozjpeg 批次圖片壓縮 - 延伸篇)

📆 2019-03-30

📁

多媒體, 網站技術, JavaScript, Node.js, 靜圖處理, Gulp

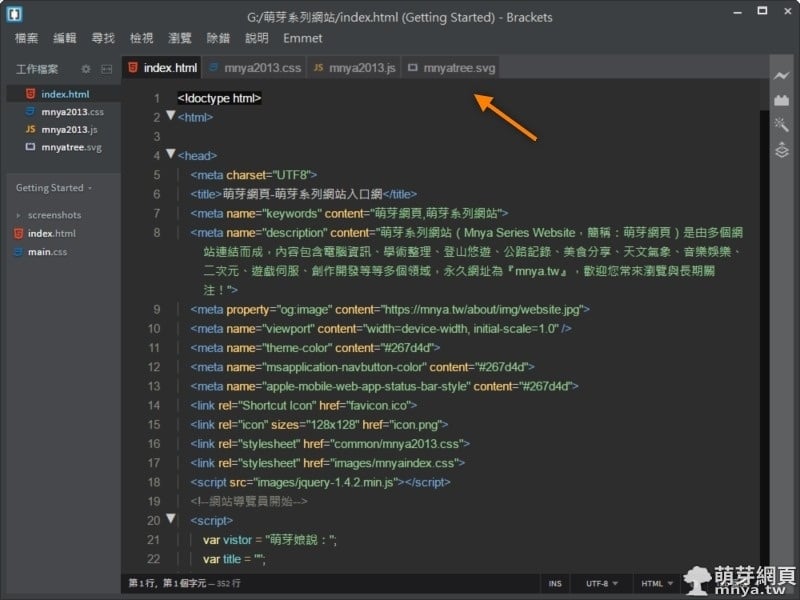

Brackets 擴充功能「Documents Toolbar」:讓軟體上方有頁籤可切換檔案

📆 2018-09-21

📁

軟體應用, 網站技術

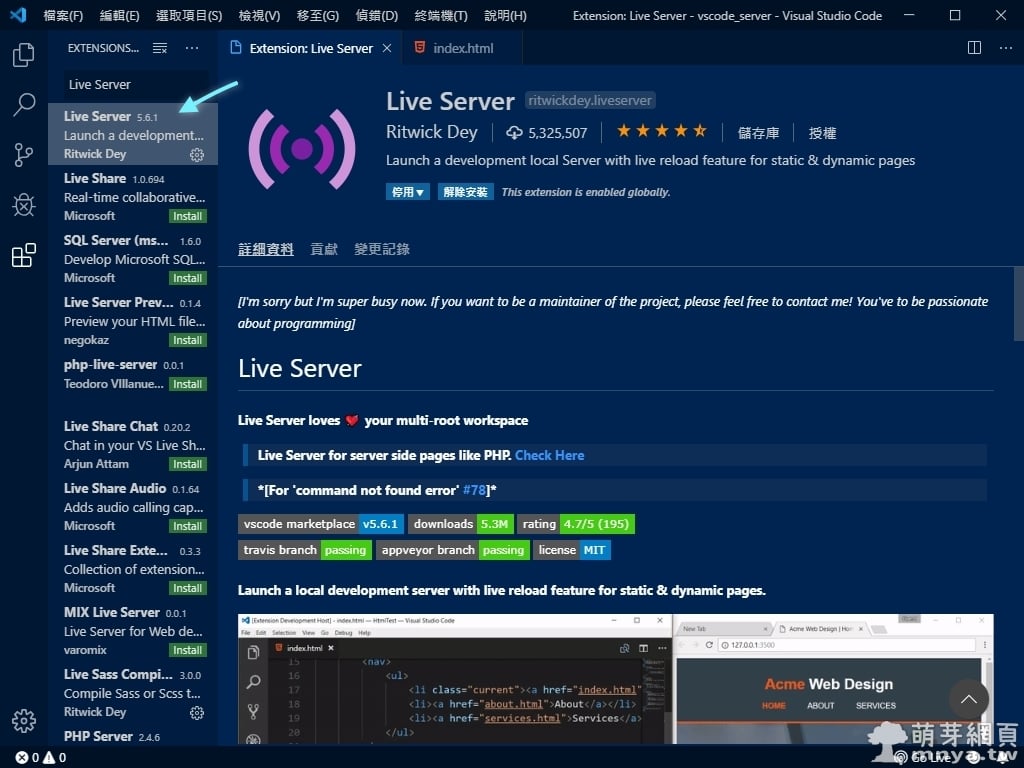

Live Server(Visual Studio Code 擴充功能):編輯器內即時更新的本機伺服器

📆 2019-08-19

📁

軟體應用, 網站技術

《上一篇》detrois 光學滑鼠專用矽膠滑鼠墊

《上一篇》detrois 光學滑鼠專用矽膠滑鼠墊  《下一篇》Mini DisplayPort to VGA 連接線

《下一篇》Mini DisplayPort to VGA 連接線

留言區 / Comments

萌芽論壇