又是一篇含金量極高的文章!AI 繪圖技術發展的越來越快速,感覺不關注一兩天就會錯過非常多新消息,而最近網上剛剛有開發者釋出 ControlNet 擴充功能給 Stable Diffusion web UI 用。至於什麼是 ControlNet?它是一種神經網路結構,透過添加額外條件來控制擴散模型。因此我們可以給 AI 提供人物骨架或者草稿,來讓 AI 進一步依照這樣的條件繪製新的圖片,簡單來說就是這樣。

🔗 sd-webui-controlnet:https://github.com/Mikubill/sd-webui-controlnet

基本上整個安裝流程跟使用方式這篇圖文會清楚告知,讓大家輕鬆上手。安裝方面,只要透過 web UI 就可以做完。使用方面,需要先取得 ControlNet 的模型,有針對提取圖中人物骨架的,也有針對草稿邊緣偵測的,依照需求下載模型,最後就能用這些模型來提取條件讓 AI 繪圖囉!馬上開始這次的圖文教學吧!

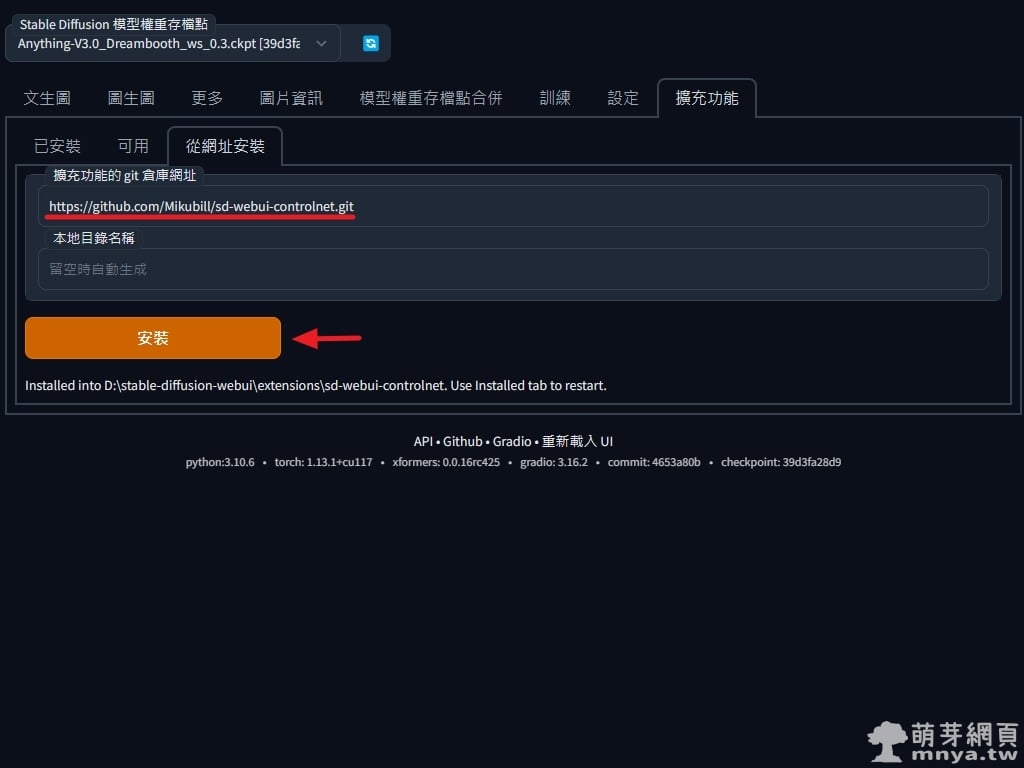

▲ 打開 Stable Diffusion web UI 切到「擴充功能」頁面,選「從網址安裝」,將擴充功能完整的 git 網址(即 https://github.com/Mikubill/sd-webui-controlnet.git)輸入進去再點「安裝」按鈕,安裝完畢可以在 stable-diffusion-webui\extensions\ 路徑下看到名為 sd-webui-controlnet 的資料夾。

▲ 切到「已安裝」,可以看到「sd-webui-controlnet」已經安裝,未來可以在此檢查更新。點「應用並重新啟動使用者介面」,這樣就成功啟用該擴充功能囉!

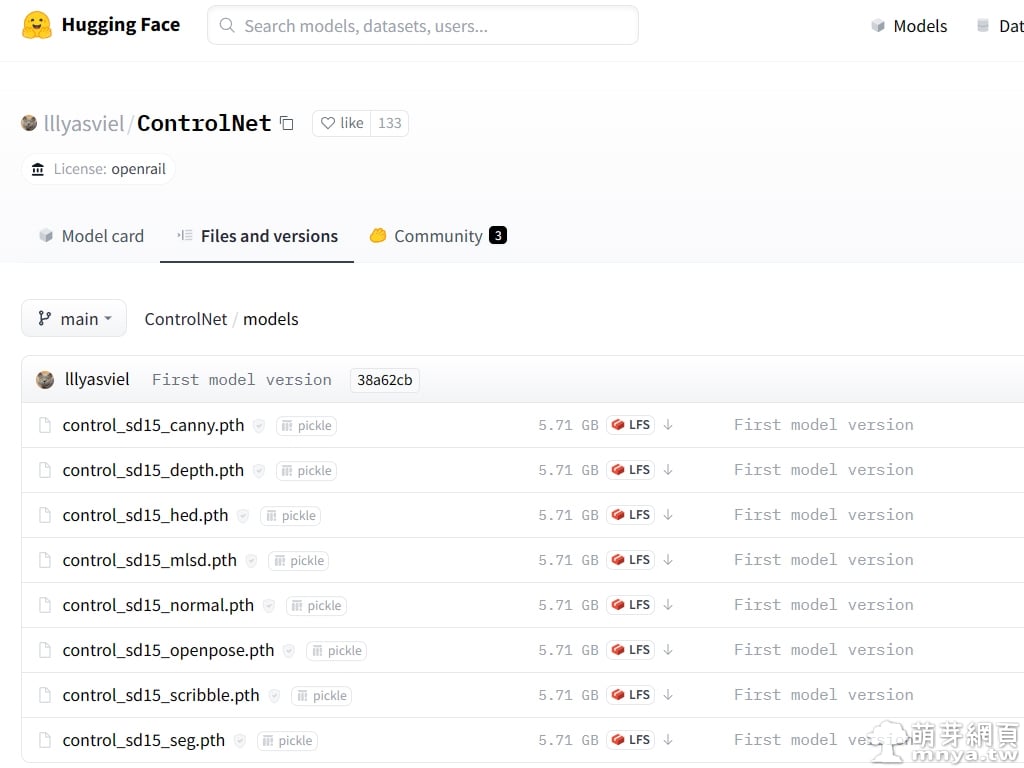

▲ 可以到 Hugging Face 找尋 ControlNet 模型,網址是 https://huggingface.co/lllyasviel/ControlNet/tree/main/models,每個模型是做什麼用的請參考這個網址 https://huggingface.co/lllyasviel/ControlNet,這邊我只下載兩個,分別是「control_sd15_canny.pth」(草稿邊緣偵測)及「control_sd15_openpose.pth」(提取圖中人物骨架)。

📝 補充:原始 ControlNet 模型有些肥大,有熱心人士製作了 fp16 輕量版模型檔案可供下載使用:https://huggingface.co/webui/ControlNet-modules-safetensors/tree/main

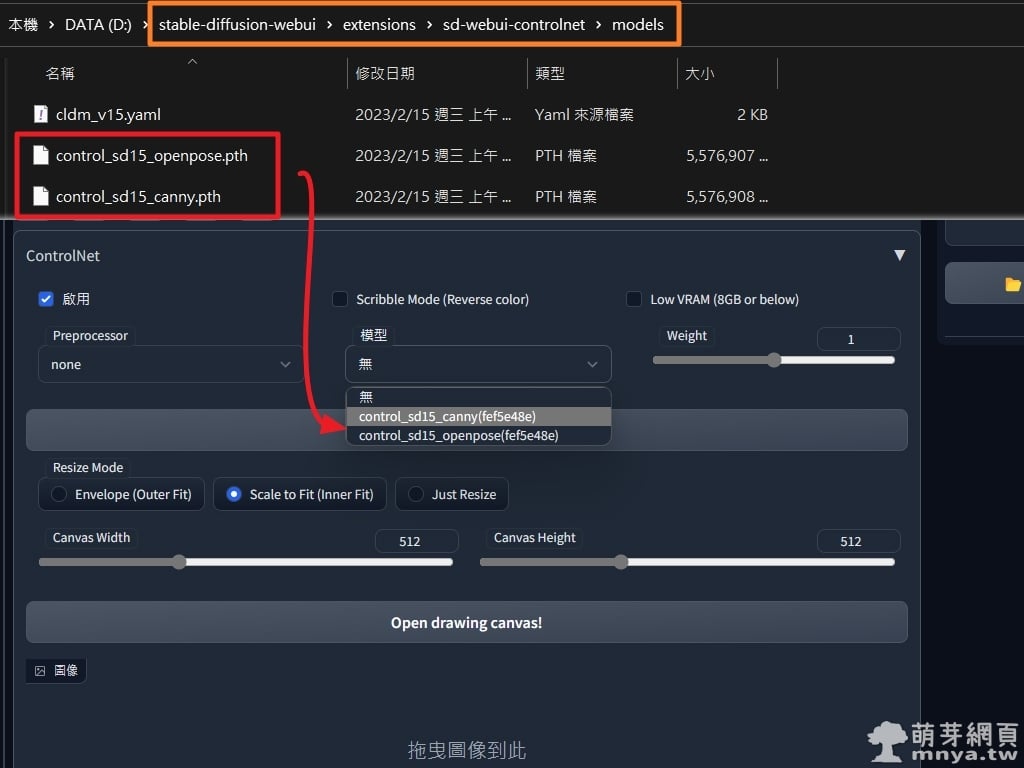

▲ ControlNet 模型請下載到 stable-diffusion-webui\extensions\sd-webui-controlnet\models,之後建議重新啟動 Stable Diffusion web UI,您可以在文生圖或圖生圖等 AI 繪圖介面中看到擴充的新面板「ControlNet」,可以在「模型」選單中看到您下載的 ControlNet 模型。

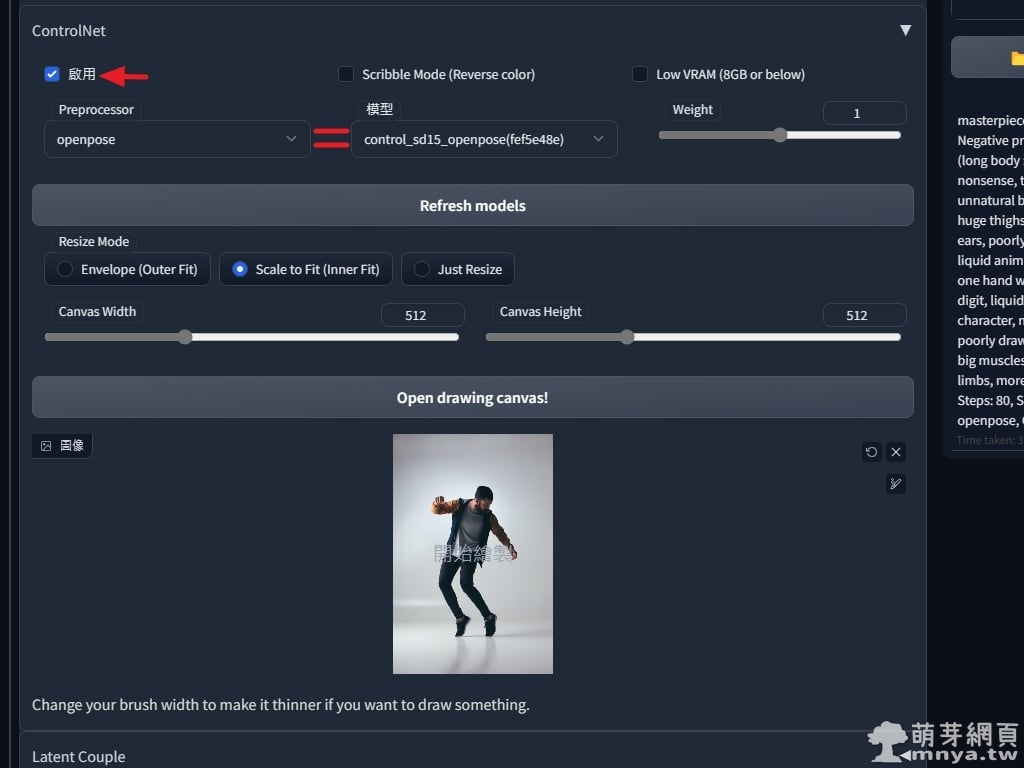

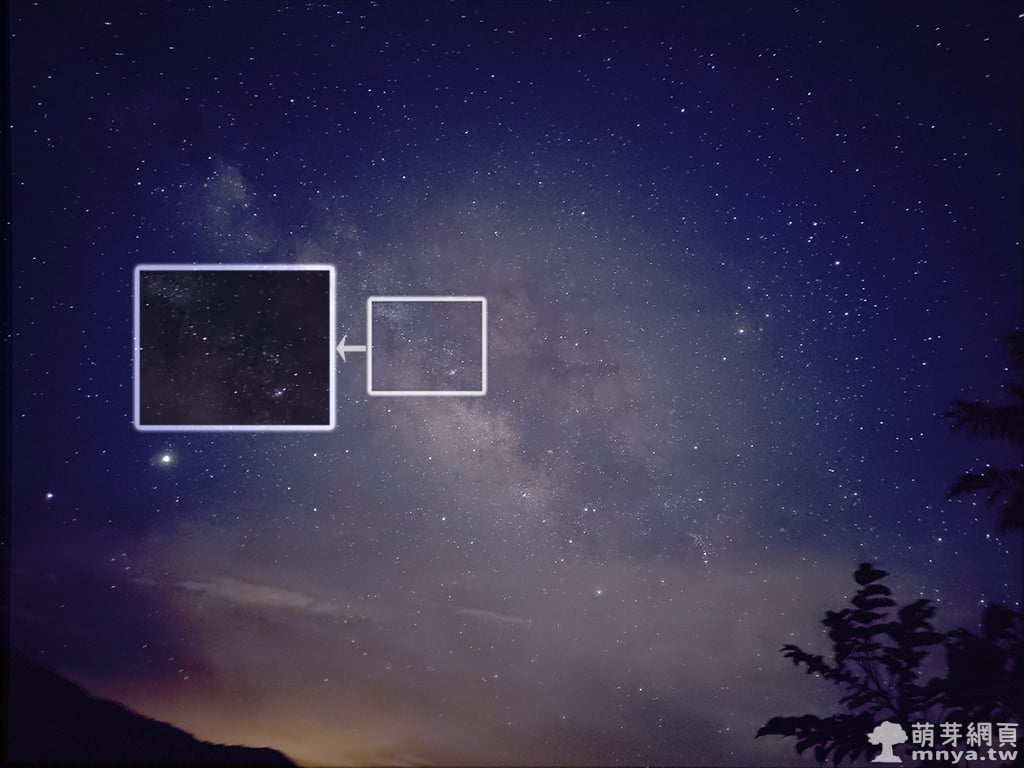

▲ 首先先來載入一張真人擺姿勢的照片(注意:建議用真人照,模型比較好取得骨架),確認「啟用」有打勾,Preprocessor 跟模型兩個選單要選一樣的,這邊就是都要選 openpose。其他就跟平常用 AI 繪圖的步驟一樣,設定提詞等參數最後按生成。(⚠️ 注意:如果您的 GPU VRAM 小於 8GB,Low VRAM 記得要勾選)

📝 補充:首次使用 ControlNet 的 openpose 模型會需要下載一些檔案,終端機輸出內容如下:

Downloading: "https://huggingface.co/lllyasviel/ControlNet/resolve/main/annotator/ckpts/body_pose_model.pth" to D:\stable-diffusion-webui\extensions\sd-webui-controlnet\annotator\openpose\body_pose_model.pth

100%|███████████████████████████████████████████████████████████████████████████████| 200M/200M [00:18<00:00, 11.4MB/s]

Downloading: "https://huggingface.co/lllyasviel/ControlNet/resolve/main/annotator/ckpts/hand_pose_model.pth" to D:\stable-diffusion-webui\extensions\sd-webui-controlnet\annotator\openpose\hand_pose_model.pth100%|███████████████████████████████████████████████████████████████████████████████| 141M/141M [00:12<00:00, 11.6MB/s]

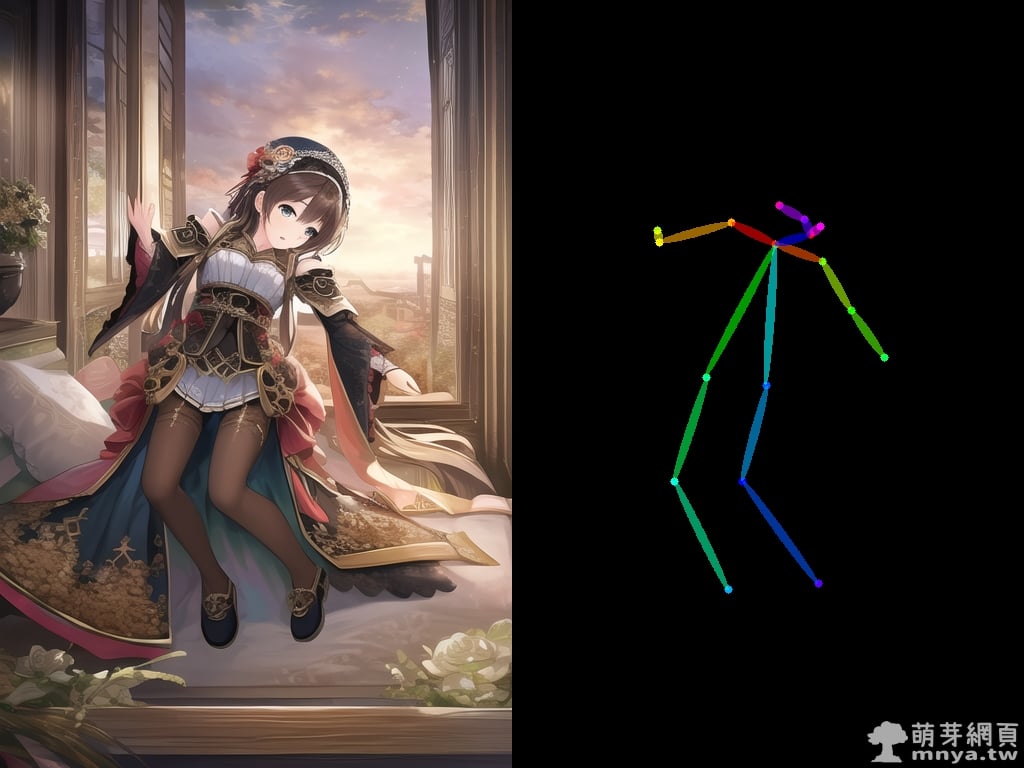

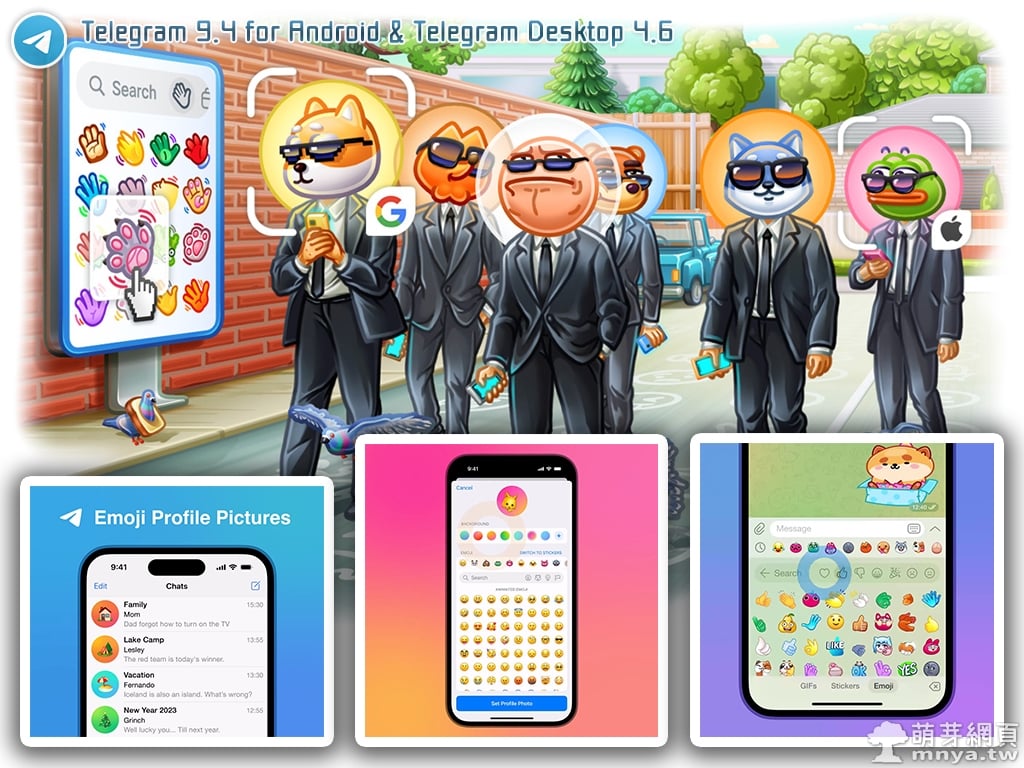

▲ 超酷的!竟然真的依照真人照片輸出骨架(圖右),並且基於該骨架條件輸出新的 AI 繪圖作品(圖左)。

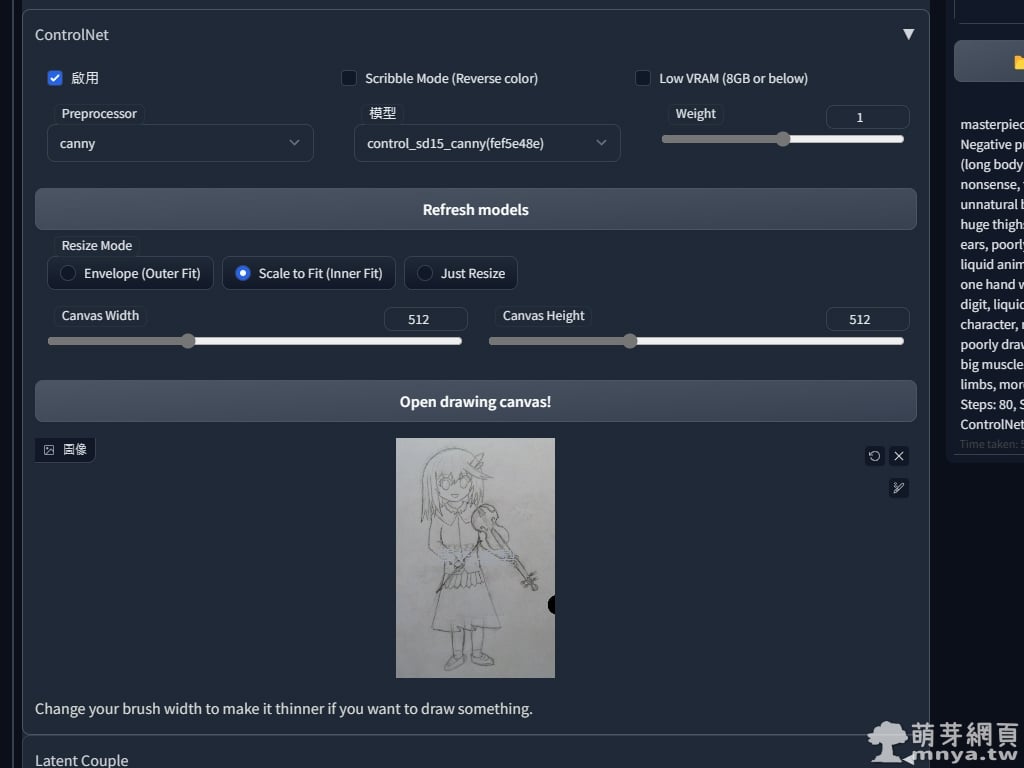

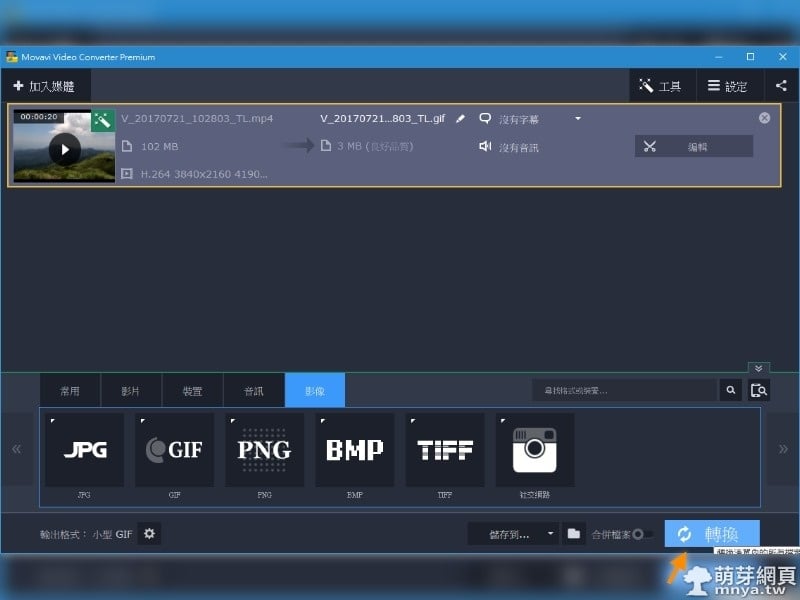

▲ 再來是將草稿載入,這次選的模型是 canny,一樣記得勾「啟用」,這別忘。(⚠️ 注意:如果您的 GPU VRAM 小於 8GB,Low VRAM 記得要勾選)

▲ 這是方塊鴨過去的萌樂手繪草稿,經過模型處理取得大多數的邊緣後,再給 AI 輸入該條件進行繪圖,得出圖左的最終結果,非常驚人!

示範用提詞:masterpiece, (best quality:1.3), Amazing, beautiful detailed eyes, 1girl, solo, finely detail,depth_of_field, extremely detailed CG unity 8k wallpaper

以上就是這次的教學,希望能幫助到大家,AI 繪圖持續發展突破中,千萬不要錯過了!學會就是你的了 😉。

👉 延伸教學一:多個 ControlNet 結合使用 (Multi-ControlNet)

👉 延伸教學二:AI 參考指定影像構圖進行重新繪圖

《上一篇》Stable Diffusion web UI 安裝正體中文翻譯擴充功能教學

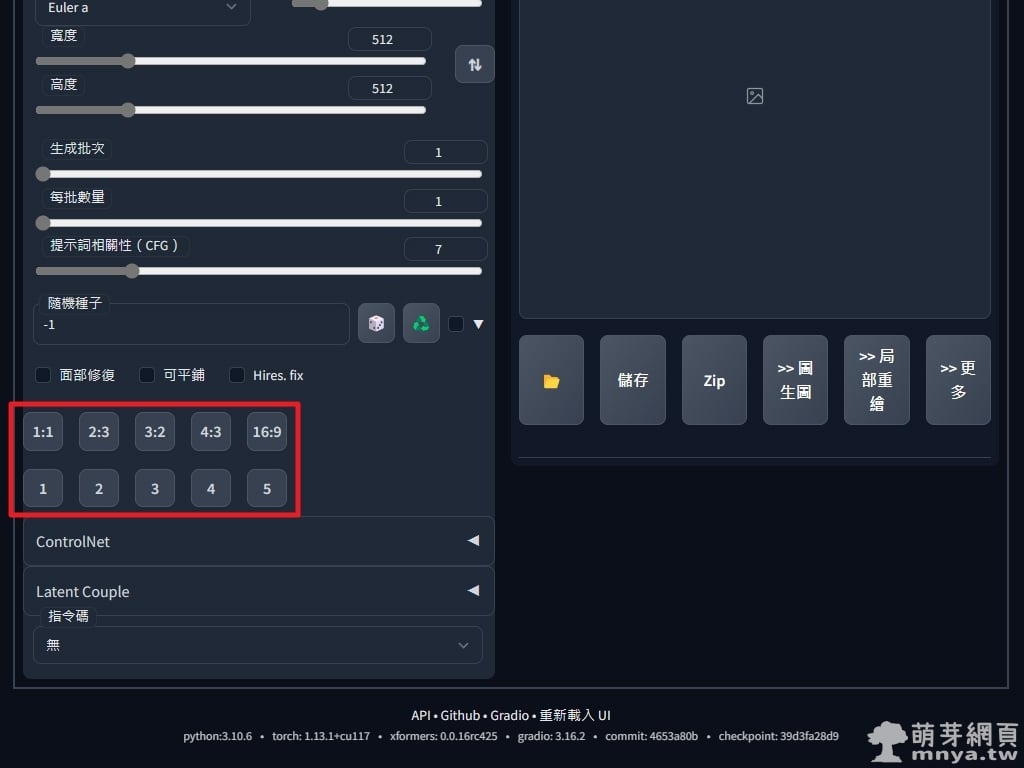

《上一篇》Stable Diffusion web UI 安裝正體中文翻譯擴充功能教學  《下一篇》Stable Diffusion web UI x Aspect Ratio selector:寬高比例、數值快速選擇器

《下一篇》Stable Diffusion web UI x Aspect Ratio selector:寬高比例、數值快速選擇器

留言區 / Comments

萌芽論壇